Les membres du CECO le savent depuis longtemps : réclamer des formats adaptés pour l’archivage sans en vérifier la conformité ne représente que la moitié du travail.

C’est la raison pour laquelle le CECO ne se contente pas de mettre à jour continuellement son Catalogue des formats de données d’archivage Cfa, mais qu’il s’active depuis des années à la validation de formats. Les réflexions de base comme celles développées dans l’étude « Reconnaissance et validation de format - Théorie et pratique » de 2012 constituent le fondement théorique qui trouve sa concrétisation dans le validateur multiformat KOST-Val.

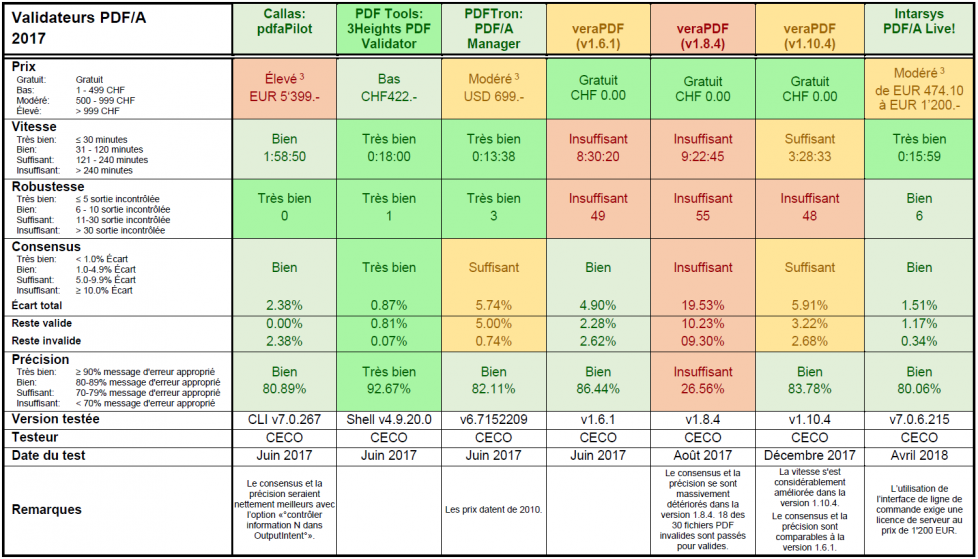

La validation du PDF/A, format essentiel pour l’archivage numérique, revêt une importance particulière. C’est pour cette raison que le CECO a testé en 2010 déjà sept validateurs et analysé les résultats pour les publier dans une étude. Après sept ans, il semble que le moment est venu de remanier entièrement cette analyse. Nous avons le plaisir de vous présenter la nouvelle étude du CECO sur les validateurs de PDF/A. Cette étude comprend encore cinq produits importants du marché parmi lesquels le nouveau validateur open source veraPDF développé dans le cadre du projet PREFORMA.

Une analyse complète de validateurs de PDF/A nécessite un corpus de test global, correct et si possible non publié de fichiers qui permettent une analyse séparée de toutes les exigences qui nous intéressent. L’ensemble de test Bavaria a mis un tel corpus de test à disposition en 2010. Cet outil est entre-temps devenu non seulement obsolète, mais il est en plus également trop bien connu. Développer un nouveau corpus de test dépasse les possibilités actuelles du CECO, raison pour laquelle la nouvelle version de l’étude sur les validateurs de PDF/A se base sur un banc d’essai de validateurs (benchmarking). Nous avons utilisé un corpus de 2980 fichiers PDF réels différents provenant de l’environnement du CECO et du groupe de travail nestor sur la reconnaissance des formats qui ont servi à tester tous les validateurs analysés.

Les aspects suivants ont été consignés (en plus de la version, du testeur et de la date du test) :

Les résultats de l’analyse sont rassemblés dans le tableau ci-après. Veuillez noter que nous avons testé trois versions différentes de veraPDF.

PDFA-Validatoren_2018.04_v1.0.pdf, 173.7K, 23.04.18

Validateurs PDF/A - version 2018.04

PDFA-Validateurs_v2.1.pdf, 43.3K, 08.12.10

Validateurs PDF/A - version 2010